Humain vs IA : Qui apprend le plus efficacement ?

Est-ce que vous avez une idée de la quantité de données nécessaires pour apprendre une tâche ?

Imaginez par exemple que vous devez apprendre à identifier différents champignons — des coulemelles, des champignons de Paris, ou encore des pleurottes. Afin de les reconnaître, vous examinez leur taille, leur couleur, leur motif, peut-être même leur odeur. De combien d'exemples avez-vous besoin pour devenir bon dans cette tâche d'identification ? Et pour une machine apprenante, de combien d'exemples a-t-elle besoin ?

En tant qu'humain, quelques exemples peuvent suffire — disons 5 ou 6 exemples pour chaque catégorie de champignons — et vous devriez être capable d'en reconnaître des nouveaux de façon assez satisfaisante. Pour un programme d'intelligence artificielle, c'est un peu différent. Une IA, en l'occurrence un classifieur apprenant, a besoin de beaucoup plus de données pour parvenir à maîtriser cette tâche. La quantité de données nécessaires va bien sûr dépendre du programme utilisé, mais on peut dire, à la louche, que 1000 exemples par catégorie c'est un minimum pour pouvoir atteindre des performances satisfaisantes. Voir, on recommande même plusieurs dizaines de milliers d'exemples par catégorie, ou encore plus. Plus les données sont nombreuses et variées, mieux c'est.

Sommes-nous tout simplement trop fort ?

Alors, pourquoi cette différence ? Il est courant de dire que l'humain est meilleur que la machine pour apprendre, qu'il consomme beaucoup moins de données. C'est sûr qu'entre 5 - 6 exemples par catégorie, contre 10000, y'a pas photo. Et, bien sûr, on adorerait pouvoir concevoir des programmes qui apprennent avec si peu de données ! C'est ce qu'on appelle le one-shot learning — l'apprentissage en un coup — et le few-shots learning — l'apprentissage en quelques coups. Quelques techniques existent pour essayer de s'en rapprocher, cependant l'être humain semble juste trop fort, et on ne parvient pas à faire apprendre à nos machines de façon si efficace.

Bon, prenons un peu de recul sur ce raisonnement.

Mettez-vous un instant à la place d'un algorithme d'apprentissage. Vous êtes donc une fonction mathématique, qui prend en entrée des données, et propose en sortie une réponse. Dans le cas présent, on vous donne en entrée un champignon, et vous répondez par une catégorie, par exemple "coulemelle". Vous vous améliorez peu à peu en recevant un retour sur vos réponses ; c'est ça qu'on appelle l'apprentissage. Et, comme pour les humains, c'est en faisant des erreurs qu'on apprend. Ce qu'il faut bien comprendre ici, c'est qu'en tant qu'algorithme, tout ce que vous avez vu dans votre petite vie d'algorithme, ce sont ces exemples de champignons, et les réponses attendues. Ces données peuvent prendre différentes formes, comme des images sous forme numérique, ou encore des mots. Mais dans tous les cas, vous n'avez rien connu d'autre.

L'apprentissage par transfert

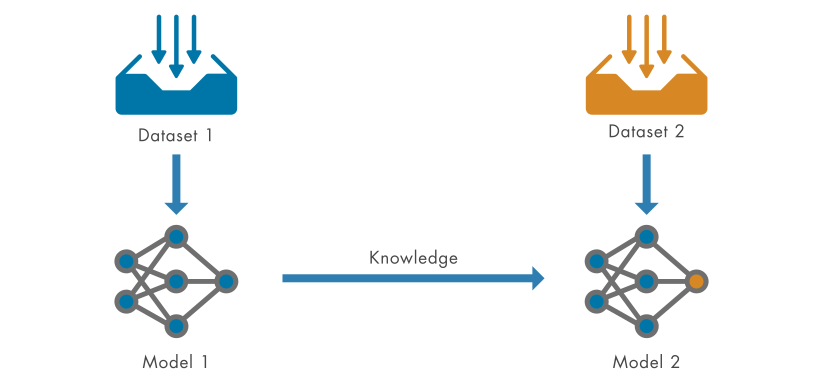

J'ai dit plus tôt qu'il existe des techniques pour permettre aux machines d'apprendre avec moins d'exemples. Ces techniques impliquent généralement un pré-apprentissage, ou de l'apprentissage par transfert. C'est-à-dire qu'on expose la machine à d'autres données avant de lui présenter le problème qui nous intéresse réellement. Par exemple on lui montre des plantes, avant de lui enseigner l'art de l'identification des champignons. L'apprentissage par transfert, c'est donc, plutôt que de partir de zéro, partir d'un algorithme qui a déjà appris des choses par le passé, et quand bien même il s'agisse d'une tâche différente, espérer qu'il va pouvoir transférer ses connaissances d'une tâche à une autre. On observe que cela aide à apprendre par la suite des choses nouvelles avec moins d'exemples.

Maintenant imaginez, si vous le pouvez, que vous êtes un être humain. Vous avez donc la capacité d'apprendre avec seulement une poignée d'exemples. Pensez-vous qu'une forme de pré-apprentissage, ou d'apprentissage par transfert, vous a permis d'obtenir cette capacité ? C'est la première fois que vous vous entrainez à l'identification de champignons. Mais par le passé, vous avez vu des oiseaux, des plantes, des animaux. Vous avez observé toutes sortes d'objets. Et pas seulement avec vos yeux : vous avez écouté leurs chants, touché le sol d'une forêt, senti le vent sur votre peau. Vous avez ressenti des sensations complexes et variées. Vous avez étudié des livres, des documentaires, sur une multitude de sujets. Quelle quantité de données représente tout ce pré-apprentissage ?

Essayons-nous à une estimation grossière. Des chercheurs ont estimé la quantité de données captée par le système sensoriel de notre corps. Ce système, c'est l'ensemble des récepteurs qui constituent nos sens, dont on estime qu'on en possède environ 100 millions, nous permettant de capter des ondes visuelles et sonores, des sensations tactiles, la chaleur ou encore la douleur. Ces chercheurs, donc, ont estimé que ces capteurs, ensemble, collectent des données sur notre environnement à un rythme d'un milliard de bits par seconde, c'est-à-dire 125 méga-octets par seconde. Cela correspond environ à un épisode des Simpsons en résolution standard, en quelque sorte téléchargé par votre corps, chaque seconde.

Un point intéressant à noter, c'est qu'il y a une différence majeure entre la quantité d'informations captées et transmises vers le système nerveux central et la quantité d'informations traitées de manière consciente. La vitesse de la pensée humaine, consciente, est estimée par ces chercheurs comme étant bien plus faible, à un débit d'environ 100 bits par seconde.

Quoi qu'il en soit, on capte donc des téra-octets d'informations chaque jour, et ce depuis le jour de notre naissance. Cumulé, cela représente une quantité de données gigantesque que le cerveau humain reçoit, traite, et utilise pour apprendre. Et cela nous permet, grâce à l'apprentissage par transfert, d'apprendre des nouvelles tâches de façon très efficace, en mêlant des connaissances et des idées ancrées dans notre intellect depuis des années.

Conclusion

En remettant en perspective tout ça, on se rend compte que les algorithmes d'IA ne consomment finalement que peu de données, car les tâches qu'on leur soumet sont extrêmement précises et spécialisées, et d'une certaine façon assez limitées. Cela dit, aujourd'hui, on tend à développer des algorithmes de plus en plus généraux et gourmands en données et en énergie.

Cette avancée technologique nous confronte au choix suivant : D'une part, nous pourrions continuer à développer des algorithmes spécialisés, des outils efficaces et économes en énergie, qui excelleront dans des tâches précises, sans prétendre à une compréhension plus large; D'autre part, nous pourrions nous aventurer vers la création d'intelligences artificielles polyvalentes, similaires aux êtres humains, capables d'utiliser un large éventail d'expériences et de connaissances, obtenant ainsi une modélisation plus sensible de notre monde. Cependant, cette dernière voie soulève des questions cruciales. En nous efforçant de modeler l'intelligence artificielle à notre image, ne risquons-nous pas de négliger les coûts énergétiques, éthiques et les impacts sociétaux qui en découlent ? Cherchons-nous à développer des outils utiles, améliorant la condition humaine ? Ou bien cherchons-nous à nous réinventer à travers nos créations, et si oui, à quel prix ?

Références

https://www.caltech.edu/about/news/thinking-slowly-the-paradoxical-slowness-of-human-behavior

https://www.cell.com/neuron/abstract/S0896-6273(24)00808-0

https://fr.wikipedia.org/wiki/R%C3%A9cepteur_sensoriel

https://en.wikipedia.org/wiki/One-shot_learning_(computer_vision)