L'IA est-elle une aberration écologique ?

Est-ce que vous avez une idée de la quantité d'électricité consommée par l'usage d'une intelligence artificielle ? Par exemple poser une question à chatGPT, ou bien générer une image. On sent bien que cette technologie ne peut pas être gratuite écologiquement, et en même temps, on a rarement une idée bien claire de l'énergie consommée par ces programmes. Certains considèrent l'IA comme une aberration écologique, là où d'autres indiquent que sa consommation est raisonnable par rapport à d'autres industries.

Alors, pour savoir ce qu'il en est réellement, et pour y voir plus clair, on va tout d'abord revenir sur quelques bases concernant l'IA, puis on va regarder ensemble des données concrètes et parlantes, notamment donc la consommation énergétique d'une requête chatGPT, ou de la génération d'une image, et comparer ces chiffres à des choses qui nous parlent, comme la consommation d'une ampoule, ou bien d'une charge complète de smartphone. Et vous allez voir qu'en vérité c'est assez affolant !

Les gros et les petits modèles

Tout d'abord, lorsqu'on parle d'intelligence artificielle, on rassemble en fait sous le même nom tout un ensemble de techniques et d'algorithmes très variés. On a d'un côté des "petits" modèles – par exemple, une simple régression linéaire ou un arbre de décision. Ces modèles sont recommandés dans un grand nombre d'applications, et on a intérêt à les utiliser quand c'est possible, car ils demandent relativement peu de ressources. Cependant, pour répondre à des problèmes complexes, ils peuvent s'avérer limités. Et donc bien sûr, de l'autre côté du spectre, on a les géants, typiquement les systèmes de génération de texte ou d'images, basés sur des architectures massives. Aujourd'hui quand on parle d'IA, bien souvent on pense à ce type de programmes, aux capacités impressionnantes, mais demandant beaucoup plus de ressources, aussi bien pour leur entraînement que pour l'inférence. On va revenir sur cette distinction dans un instant. Ici on va donc s'intéresser à la consommation énergétique des gros modèles. Ce qui ne veut pas dire que les petits modèles ne consomment rien. Mais leur usage n'est pas différent des usages classiques d'internet comme effectuer une recherche Google, utiliser une messagerie, ou simplement naviguer. On va donc laisser de côté les modèles simples.

Étudions, donc, la consommation énergétique de ces intelligences artificielles. Il y a essentiellement deux étapes pendant lesquelles on a besoin de ressources : l'entraînement et l'inférence.

L'apprentissage et l'inférence

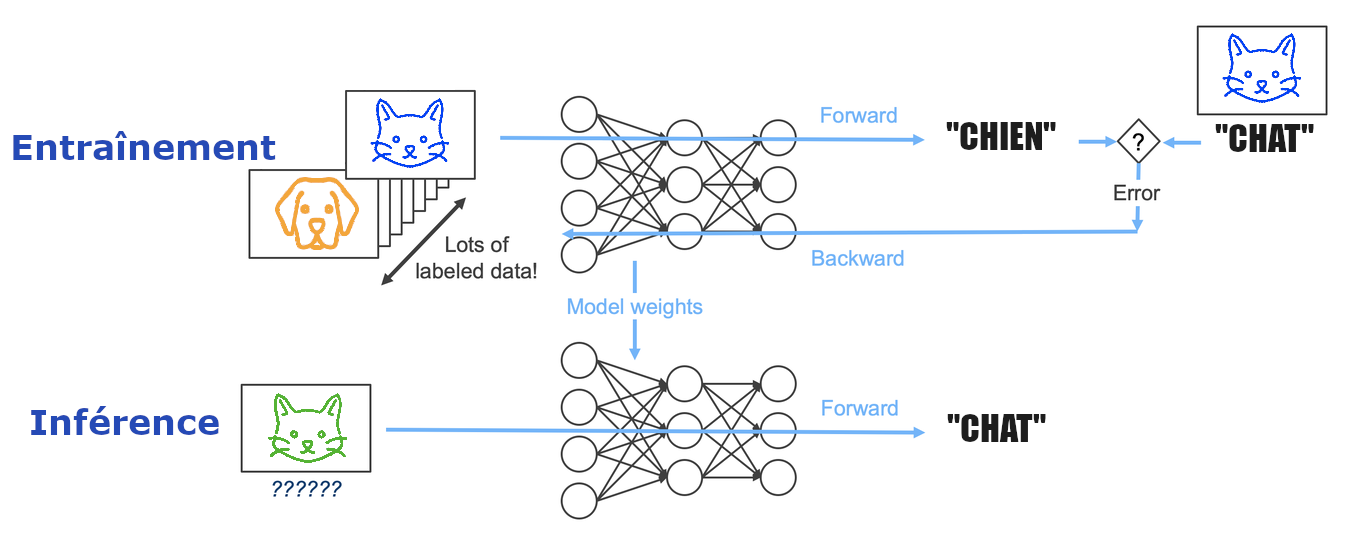

L'entraînement, ou l'apprentissage, c'est le moment où le modèle se construit à partir de données. C'est ce qui fait toute la particularité de l'IA actuelle : il s'agit d'apprentissage automatique. C'est-à-dire qu'au moment où on écrit le programme, et qu'on le lance pour la première fois, il est parfaitement incapable de résoudre la tâche qu'on veut lui faire faire. Puis on va lui montrer des exemples, les données, et petit à petit le programme va s'améliorer, de manière relativement autonome, jusqu'à devenir performant. Par exemple on lui montre 10,000 photos de chiens et de chats en lui demandant ce qu'il voit et en le corrigeant. Au début, les réponses sont aléatoires, mais peu à peu l'algorithme s'améliore et trouve les bonnes réponses. Cela signifie qu'on peut enseigner n'importe quoi à notre modèle, et c'est ce qui est intéressant, mais on peut également lui apprendre des choses complètement fausses ! Par exemple, si on inverse les chats et les chiens dans nos données, le modèle deviendra parfaitement expert dans l'art de confondre les chats et les chiens. Cette phase d'entraînement, elle peut représenter une quantité de calcul phénoménal. Typiquement, les LLMs modernes parcourent, durant leur apprentissage, des données qui correspondent en gros à tout le texte disponible publiquement sur internet. La bonne nouvelle, c'est qu'une fois l'apprentissage terminé, c'est fait. Les connaissances sont sauvegardées et on peut utiliser le modèle à volonté, sans avoir besoin de l'entraîner à nouveau.

Et justement, quand on utilise le programme, on rentre dans la deuxième étape : l'inférence. L'inférence, c'est simplement envoyer une requête à une IA déjà entraînée pour obtenir une réponse. Pour reprendre notre exemple précédent, on envoie une photo et on reçoit une réponse : "chien" ou "chat". Une requête envoyée à un générateur d'images ou de texte, correspond également à une inférence. On parle d'"inférence" parce que le modèle "infère" un résultat en se basant sur les connaissances acquises lors de son entraînement. L'inférence consomme beaucoup moins d'énergie que l'apprentissage. Mais d'un autre côté, là où l'entraînement ne se fait qu'une seule fois, les inférences, les requêtes, peuvent être très nombreuses.

Les chiffres de la consommation

Maintenant qu'on a posé le décor, voyons les chiffres. On donc veut savoir à quel point les gros modèles proposés par des entreprises comme Meta, Google ou OpenAI, sont énergivores. En fait, c'est assez difficile de répondre à cette question, parce que ces entreprises ne communiquent quasiment pas ces informations. Mais différents groupes de chercheurs sont tout de même parvenus à obtenir des estimations intéressantes.

Concernant l'entraînement des LLMs comme LlaMA ou GPT, l'ordre de grandeur qui revient, c'est qu'on fait tourner des milliers de cartes graphiques pendant 2 à 4 semaines. Cela vaut, à la louche, une consommation de 500 millions de Wh, l'équivalent de la consommation annuelle de 100 foyers français. C'est assez énorme. C'est énorme, mais comme on l'a vu, l'entraînement n'intervient qu'une seule fois. On va donc s'intéresser plutôt à l'inférence, c'est-à-dire à l'usage.

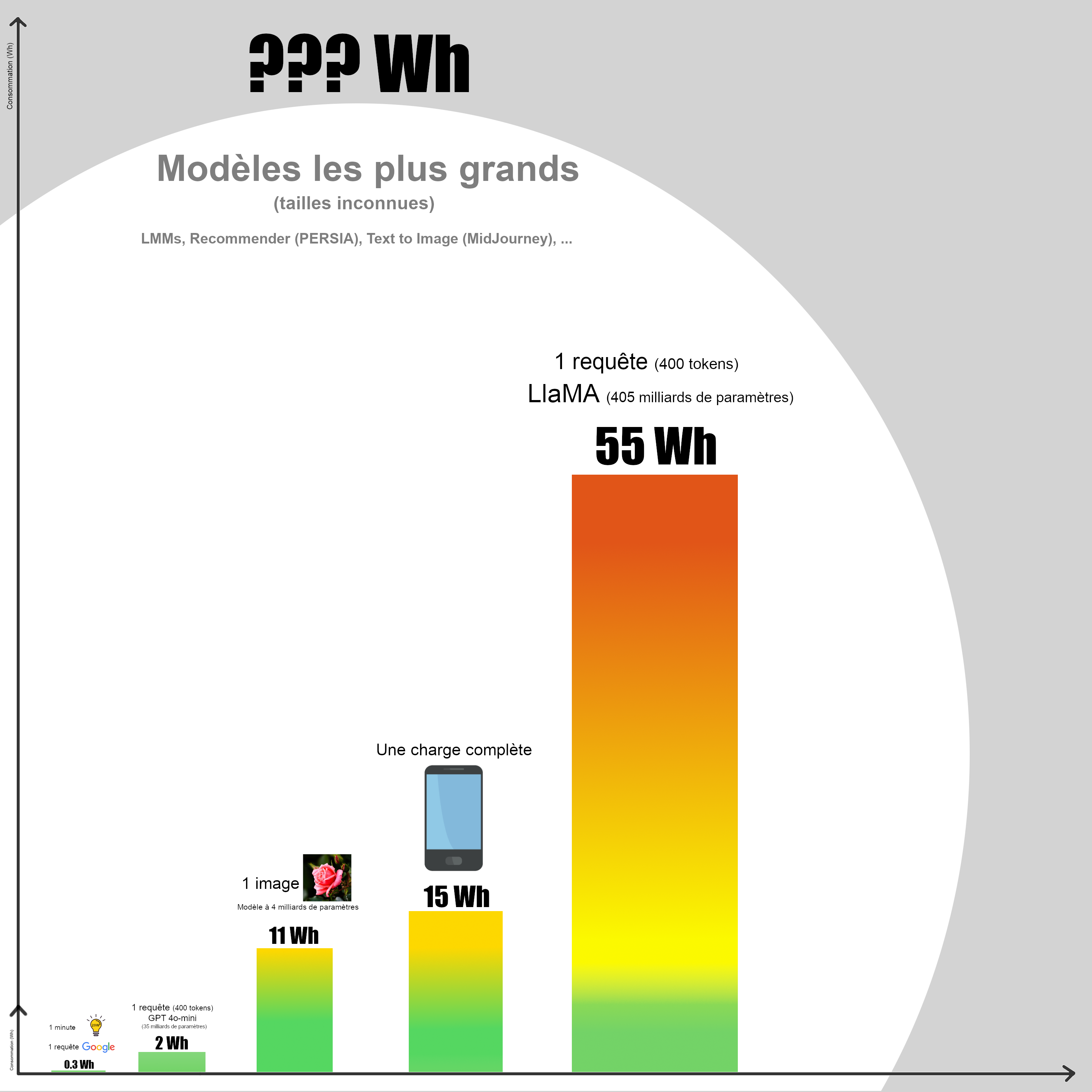

Comme point de référence, sachez qu'une recherche Google classique consomme environ 0.3 Wh. C'est également la consommation d'une ampoule de 20W allumée pendant 1 minute, et non pas d'ailleurs pendant 1h ou même 24h comme on l'entend parfois.

Une requête chatGPT de 400 tokens, c'est-à-dire environ 300 mots, sur le modèle 4o-mini, consommerait environ 2 Wh. C'est déjà 6 fois plus que la recherche Google classique, pour un modèle comprenant 35 milliards de paramètres.

La génération d'une image a été estimée à 11.5 Wh. Ça commence à grimper, d'autant plus cette estimation a été réalisée sur un modèle dont la taille reste relativement raisonnable avec 4 milliards de paramètres. Et comme ça commence à grimper, on va prendre un nouveau point de référence : La charge complète d'un smartphone consomme en moyenne 15 Wh. Ce qui veut dire que générer une seule image par IA, ça consomme déjà presque autant qu'une charge complète de téléphone. Sauf que ça se fait en 10 secondes.

Plus énergivore encore, une requête de texte de 400 tokens, comme celle qu'on a vu précédemment, mais sur un modèle plus large : LlaMA 3.1 de Meta, qui comprend 405 milliards de paramètres. Cette fois-ci, la requête consomme 55 Wh. Donc pour une réponse de 300 mots, répondant à une seule requête, ce modèle consomme l'équivalent de plus de 3 charges complètes de smartphone, ou 180 recherches Google. Là ça devient inquiétant. Mais il y a plus inquiétant encore.

J'ai mentionné que les entreprises ne partagent que très peu les informations liées à leurs modèles d'IA. Les chiffres auxquels on a accès sont donc basés sur des modèles bien connus, sur ce que l'on veut bien nous laisser voir. Mais qu'en est-il de la consommation des plus grands modèles d'IA actuels ? Des chercheurs semblent indiquer que la génération d'images et de vidéos consomme plus que la génération de texte. Mais on ne sait rien à propos de ces grands générateurs, comme les dernières versions de DALLE-E ou de MidJourney. On ne sait pas leurs tailles, mais au vu de leurs performances, il est raisonnable de penser qu'ils sont composés de milliards de paramètres, et que chaque inférence équivaut au moins à une charge de téléphone, voir peut-être beaucoup plus. Et il y a également d'autres types d'algorithmes, plus discrets, comme par exemple les algorithmes de recommandation. Pour rappel, dans l'épisode sur les algorithmes de recommandation, on a vu que PERSIA, l'algorithme de TikTok, comprenait 100 000 milliards de paramètres, 250 fois plus que LlaMA, le modèle le plus gourmand dans notre comparaison. Allez savoir la consommation de ce genre de monstre.

L'industrie dans son ensemble

On a maintenant une idée plus claire de la consommation des modèles d'IA. On a vu notamment que la génération d'une seule image consomme déjà plus de 10 Wh, ce qui est comparable à la charge complète d'un téléphone. Et bien sûr, des requêtes, il y en a un grand nombre effectuées chaque jour. En combinant tous les services d'IA, on peut raisonnablement estimer que des centaines de millions de requêtes sont effectuées quotidiennement, voire davantage. En 2022, l'ensemble des data centers liés à l'IA et aux cryptomonnaies représentaient environ 2% de la consommation électrique mondiale. Et cette proportion est évidemment en augmentation, au point où de nombreux experts s'accordent à dire qu'elle pourrait doubler d'ici 2026.

Jusqu'ici on ne parle que de la consommation électrique. Cependant, les questions liées à l'écologie sont complexes, et multi-factorielles. D'où provient l'énergie ? Provient-elle de centrales à charbon ou de centrales nucléaires ? Quelle est la qualité de l'infrastructure matérielle, des ordinateurs ? Quel est le coût écologique de leur fabrication ? Tous ces facteurs sont bien entendu déterminants pour évaluer l'impact environnemental de la technologie. Et on se rend compte également, que nos machines ne sont pas du tout efficaces énergétiquement.

À titre de comparaison, le cerveau humain possède une consommation estimée autour de 20 W. Sur notre échelle, on peut donc le situer au même niveau que l'ampoule. Et pourtant, notre cerveau est effectivement capable d'effectuer des tâches d'une complexité phénoménale ! Et en termes de taille, en comptant les neurones et leurs synapses, on pourrait comparer le cerveau à un modèle d'IA gigantesque ayant 200 000 milliards de paramètres. On a donc accès à cette puissance de calcul, si je puis dire, pour une consommation énergétique dérisoire. Et en fait c'est assez intuitif : l'organisme humain entier tourne avec 2000 kcal par jour. On mange un poulet, 2 - 3 bananes et on est parti pour la journée. Cela montre, au passage, que la nature fabrique, à travers l'évolution, des systèmes extrêmement efficace. Et malheureusement, nos ordinateurs sont très loin de ces performances, et on compense en brûlant de grandes quantités de ressources.

Est-ce qu'on fonce dans le mur ?

Bon, revenons à la question initiale : L'intelligence artificielle est-elle une aberration écologique ? On a vu que les IA modernes sont très énergivores, et que le secteur, ajouté à celui des cryptomonnaies, représente plus de 2% de la consommation électrique mondiale. L'IA ne représente donc qu'une partie de la consommation énergétique, et reste inférieure à d'autres secteurs traditionnels comme la sidérurgie, l'aviation ou encore certains pans du numérique comme le streaming vidéo. Cela dit, la dynamique est en pleine explosion, et l'expansion rapide des modèles de plus en plus massifs laisse craindre un bond exponentiel de l'empreinte écologique associée.

Alors, existe-t-il un espoir d'inverser la tendance ? Tout d'abord, on peut espérer parvenir à développer des modèles qui obtiennent les mêmes performances à moindre coût. En effet, une partie de la recherche se concentre sur la frugalité des systèmes, c'est-à-dire trouver des architectures plus sobres en énergie et en ressources, capables de préserver — voire d'améliorer — les performances tout en minimisant leur impact environnemental et économique. De plus, la question de la consommation énergétique est indissociable de la question politique : Un téraflop nourri au charbon n'émet pas le même CO2 qu'un téraflop alimenté au nucléaire.

Et pour finir, l'usage de ces technologies lui-même doit être contrôlé, car toutes les requêtes ne se valent pas. Entre une requête faite par un collégien qui veut que l'IA fasse ses devoirs à sa place, ou une requête faite par des chercheurs pour étudier une question épineuse, ou encore pour diagnostiquer des maladies à partir de données radiologiques... Le coût énergétique est identique, la valeur sociale ne l'est pas. Tâchons donc d'orienter la puissance de l'IA vers la santé, la recherche, la transition écologique ; et limitons‑la pour les usages futiles.

Mal utilisée, l'intelligence artificielle carbure au vide là où elle pourrait propulser le progrès. À nous de décider si chaque inférence sera un déchet de plus... ou un pas en avant.

Références

Rapport de la DRANE :

https://drane-versailles.region-academique-idf.fr/spip.php?article1167

Comparaison de consommation de différents modèles :

https://arxiv.org/pdf/2311.16863

Consommation d'une recharge de smartphone :

https://elmy.fr/guide/appareils-electriques/multimedia/consommation-chargeur-telephone

Taille du cerveau humain :

https://fr.wikipedia.org/wiki/Neurone#D%C3%A9nombrement

La consommation pourrait doubler :

https://itsocial.fr/contenus/articles-decideurs/lia-les-datacenters-et-les-cryptomonnaies-doubleraient-leur-consommation-electrique-dici-2026/

Consommation des IAs :

https://www.polytechnique-insights.com/tribunes/energie/ia-generative-la-consommation-energetique-explose/

Consommation comparée aux smartphones :

https://www.bfmtv.com/tech/intelligence-artificielle/creer-une-image-par-ia-peut-consommer-autant-d-energie-que-recharger-un-smartphone_AV-202312040549.html